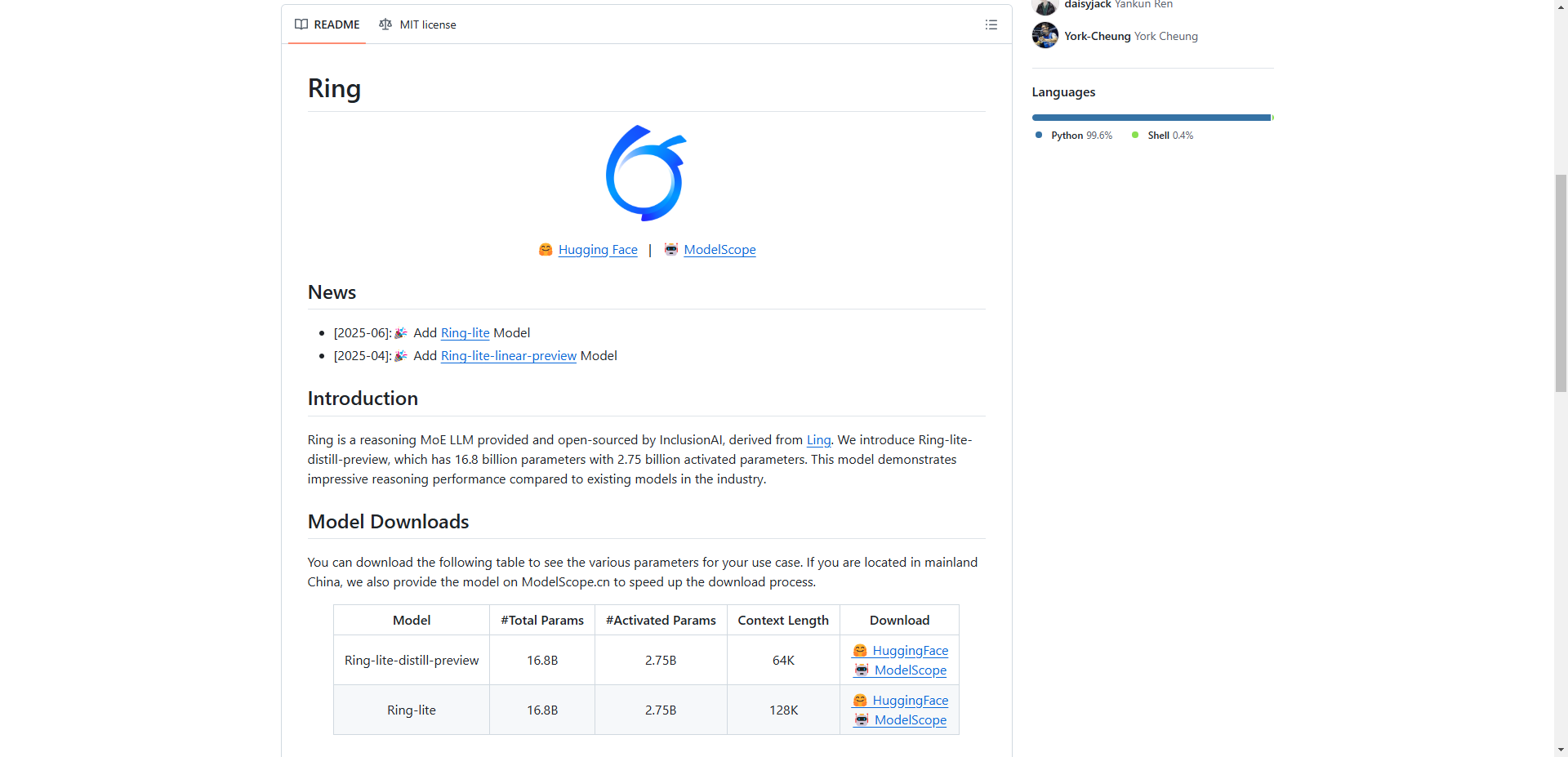

科技圈又来放大招了!蚂蚁技术团队最近官宣开源了一个叫Ring-lite的轻量级推理模型。这玩意儿可不简单,直接在好几个推理能力排行榜上霸榜,拿下了SOTA,再次证明了MoE架构有多能打。

这个Ring-lite可以说是站在巨人肩膀上,基于之前的Ling-lite-1.5升级而来。它用的就是现在很火的MoE架构,总参数有168亿,但干活的时候只激活27.5亿,主打一个“四两拨千斤”。就靠着这股巧劲和独创的C3PO强化学习大法,它在AIME、LiveCodeBench这些顶级推理竞赛里大杀四方,甚至能跟比它大三倍的Dense模型掰手腕,简直是卷王本王了。

那么问题来了,它为啥这么牛?技术上,团队搞了好几个骚操作。首先是那个首创的C3PO强化学习训练法,直接把AI训练时回答长短不一、性能忽高忽低的“老大难”问题给治好了。而且,人家还找到了长思维链SFT和强化学习的“黄金配比”,用一种新方法平衡了训练效果和效率,让模型进化得又快又好。

这还没完,Ring-lite还是个“文理双全”的学霸。它直接硬刚了多领域数据一起训练的难题,搞清楚了怎么混着练效果最好,在数学、代码、科学这三大领域实现了“1+1+1>3”的奇效。所以在各种复杂的推理任务里,尤其是在解数学题和搞编程比赛这块,它的分数遥遥领先,把对手甩在身后。

光说不练假把式,团队直接把Ring-lite拉去“高考”现场了!让它做了高考的数学和物理题,结果你猜怎么着?在数学全国一卷上,它直接考了130分左右!这成绩,放我们那时候妥妥的学神级别了,简直离谱。

最最重要的是,蚂蚁这次格局打开了!Ring-lite的开源可不是闹着玩的,人家不仅把模型和代码给你,后面还要把所有训练数据、参数配置,甚至是实验笔记都一步步公开。这简直是把家底都掏出来给你看啊,可能是轻量级MoE模型里第一个这么干的,对我们这些搞研究和开发的朋友来说,简直是天降宝藏!

GitHub:

https://github.com/inclusionAI/Ring

Hugging Face:

https://huggingface.co/inclusionAI/Ring-lite

ModelScope:

https://modelscope.cn/models/inclusionAI/Ring-lite